2018.03.20

【Siri】ユーザのプライバシーを配慮した もっとも身近で安全なAIアシスタント

Apple製品に組み込まれたAI技術は、実にさまざまな部分に及んでいる。しかし、ユーザがもっとも身近に感じ、「AppleのAI」という言葉から直接的に想起されるのは、音声アシスタントの「Siri」だろう。

当初は気恥ずかしく思えた音声による呼び出しも、慣れれば特定の処理や操作を迅速に行える手段として定着しつつある。ある調査によれば、既存の操作方法と比べた場合、Siriを利用することで、検索は2倍、ツイートなどの投稿も2倍、アラームのセットは4倍速くなるという結果が出ている。また、2015年の時点でSiriに対する問いかけが、すでに週あたり10億回に達していたことをAppleが明らかにしており、その後も順調に利用頻度が高まっていることは予想がつく。

Siriは元々、SRI(スタンフォード大学研究所)の国際AIセンターにおける研究から生まれた技術を源流とし、その研究者たちがスピンアウトして設立したソフトハウスにより、iOS向けにリリースされた音声アシスタントアプリがベースとなっている。Appleは、そのアプリを企業ごと買収し、改良を加えてOSレベルの機能として組み込んだのだ。

Siriの名称は、「Speech Interpretation and Recognition Interface(発話解析・認識インターフェース)」に由来しているが、実際には認識したあとに行える処理の幅広さがユーザにとっての最大のメリットとなるため、認識精度の向上とともに、バックエンドのサービスをいかに充実させるかにバージョンアップのポイントが置かれてきた。

当初、SiriはiOSデバイスのホームボタンを押して呼び出す方式だったが、進化の過程で、"Hey Siri"の起動ワード(ウェイクワードともいう)によってハンズフリーで使えるようになった。それにより、料理や運転中で手がふさがっているときにも使いやすくなり、利用範囲が広がったが、このことは音声によるインタラクションが将来的なユーザ体験において重要な位置を占めることを、Apple自身が強く認識していたからにほかならない。

にもかかわらず、スマートスピーカの分野で出遅れたのは、近年の同社が、iPhoneをはじめ既存のスマートデバイスの成功体験から抜けきれなかったためともいえる。これに対して、スマートデバイスの足がかりがなかったAmazonは、2014年に自社ブランドのスマートフォン「Fire Phone」を発売するとともに、スマートスピーカである初代「Echo」の試験販売を開始したものの、前者が完全な失敗に終わったことから、不可避的に後者に注力する流れとなった。

iOSのSiriは2014年にソフト的な対応で充電時の音声起動を可能とし、Echoの一般販売が開始された2015年にハードの改良で常時音声起動をサポートしたが、その間に、スティーブ・ジョブズ氏の何らかのひらめきと指示があったとしても、あながち間違いではないように思う。いずれにしてもSiriは、今後の同社のビジネス戦略において非常に重要な位置づけにある。それは純正のARグラスのような、物理的な入力インターフェイスが適さないウェアラブルデバイスが、やがてスマートフォンに取って代わるような世界に備えているためと考えられよう。

そのためにも、Appleが重視するのは、Siriが扱う情報のプライバシーである。GoogleやAmazonが、検索やスマートスピーカから得たデータを究極的には広告関連事業のマーケティングに利用したり、自社のEコマース事業の拡大に活用しているのに対して、Appleは得られた情報をSiri関連の技術やユーザ体験の向上以外の目的では使わないことを明言している。そのため、他社のAIアシスタントと比較して、できることが限られたりもするが、その分、安心して使える技術になっているのだ。

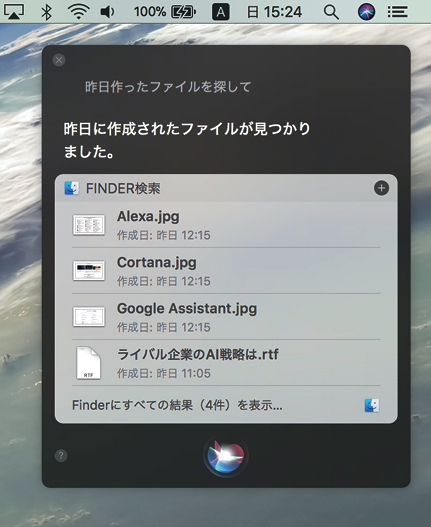

Siriは、今ではmacOSにも組み込まれ、OS自体の機能の違いから、さらに細かい作業を指示できる。また、アクセシビリティの設定次第で、Siriを音声ではなくタイプ入力でも使える。iOS 11でも、Siri起動後にタイプ入力が可能となったが、どちらも基本は音声入力だ。

Siriのテクノロジー(1) 安全で効率的な音声認識

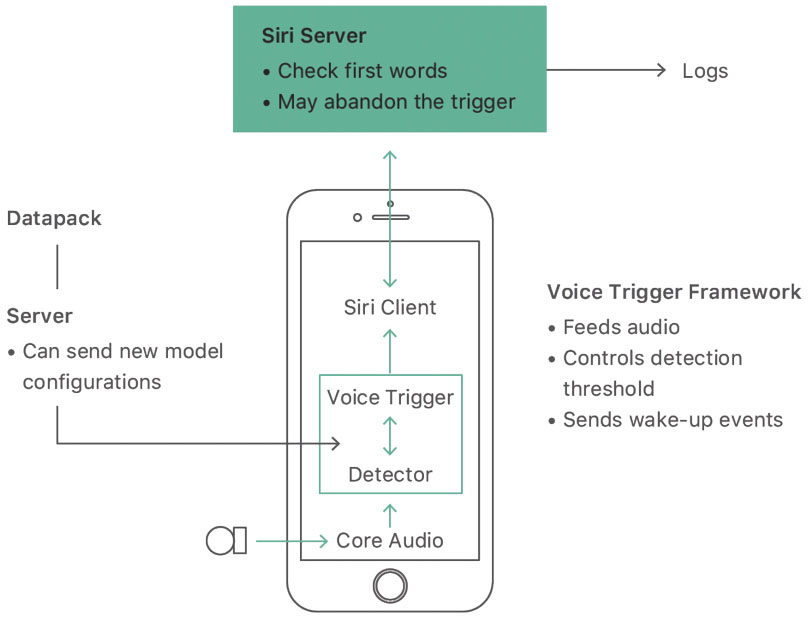

Siriは、iOSデバイスでは2015年のiPhone 6sとiPhone 6s Plus以降、常時、"Hey Siri"の起動ワードによって、ハンズフリーで使えるようになった。そのため、スリープ時も含めて周囲の音を聞き取る必要があり、プライバシーの問題が懸念されたが、Appleは2段階の措置を講じている。

まず、起動ワードが発せられるまでは認識処理をデバイス上でローカルに行い、音声を保存も送信もしないことで聞き取りを「その場だけ」のものとした。

しかし、本格的な音声認識と意味解析や、それ以降の処理には、それなりの処理パワーとネット上のリソースが必要となる。そこで、ユーザの質問や要求部分の音声は暗号化され、匿名のSiri IDとともに遠隔地にあるSiriサーバに送られて、個人が特定されないようにクラウド上で処理されるのだ。

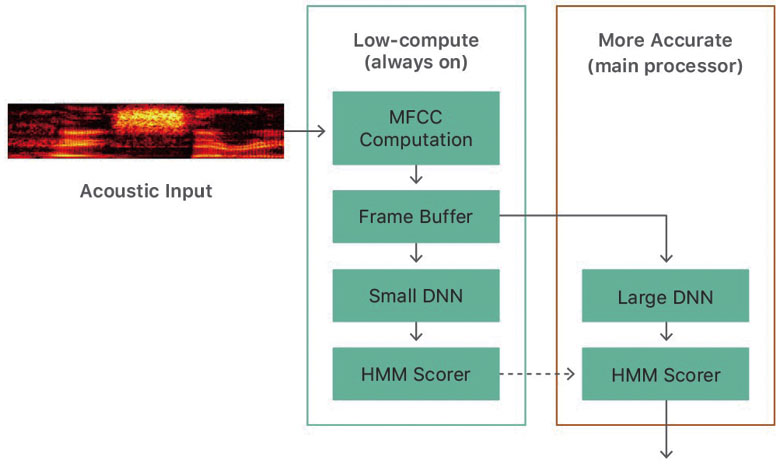

また、モバイル機器で、スリープ時も含めて常に起動ワードを正確に聞き取って認識し続けるのは、処理の負荷や電力消費の点で辛い。そこでAppleは、大まかな認識しかできないが超低消費電力のAOP(オールウェイズ・オン・プロセッサ)をモーションコプロセッサ内に組み込み、その認識結果があるを超えると、はじめて消費電力の大ききなメインプロセッサで詳細な認識を行うことで、バッテリの持ちと正確な処理を両立させている。

Siriの音声認識は、Core Audioを介して入力された音声に起動ワード(Hey Siri)が含まれるかをDetectorが判定し、含まれていれば、続く音声が暗号化・匿名化され、サーバに送られて処理される。【URL】https://machinelearning.apple.com/2017/10/01/hey-siri.html

起動ワードの認識は2段階で行われ、まず常時聞き取りを行う低消費電力のAOPというプロセッサが初期の判定を行い、ある閾値を超えるとメインプロセッサでより厳密に判定される。

Siriのテクノロジー(2) 高度な自然言語処理

音声認識は「音声をテキスト化するところまで」であり、その結果として得られた文章の意味を理解するためには、まったく別のプロセスが必要となる。それが、自然言語処理だ。

自然言語処理は、さまざまな要素が絡み合う複雑なもので、大きく分けて、単語分解、構文解析、意味解析の3つの部分から構成される。単語分解では、大量の辞書データや文法ルールを用いて文章を品詞単位に分解する。次に、この品詞情報を基に文章内の係り受けの関係を判別し、文章構造が解析される。そして、改めて大量の類義語や反義語の辞書データや統計解析的な手法を使い、出現語のグルーピングや関連度の計算を行って、その文章が意味するところを明らかにしていく。

Siriでは、一問一答形式でのやりとりが基本となるため、特に質問や意思・意図を示す部分を明確化し、天気やニュースといった外部の情報ソースに照会したり、予約サイトなどのWEBサービスに送信して結果を返してもらう。そして、得られた生の情報を、自然な文章に変換し、音声合成技術によってユーザに伝えるのである。

あの短いやりとりの間に、これだけの処理が行われ、しかも、要求が世界中のユーザから途切れることなく送られてくることを考えると、それを支えるインフラの膨大さがわかるはずだ。

Siriが応答可能な質問の内容は、OSのバージョンアップとともに拡大し複雑化しており、それを支える自然言語処理能力も高まってきた。高度な処理が行えるのも、サーバ側で対応しているためだ。

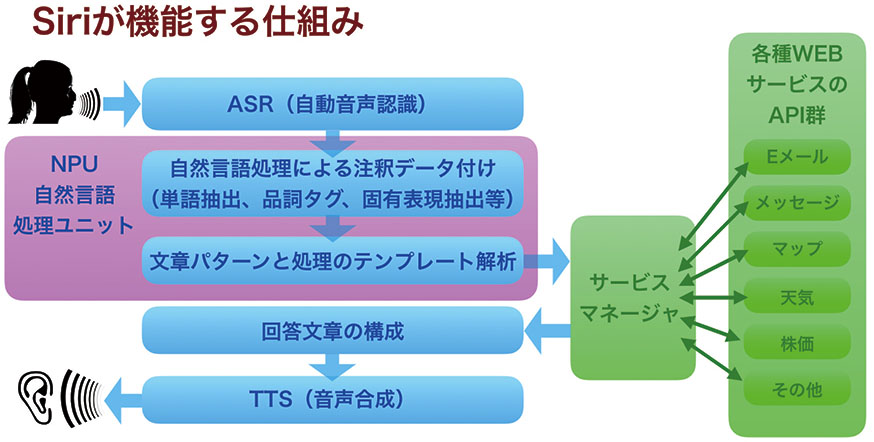

音声認識後の実際の意味解析は、ピンク色の領域内にある自然言語処理系で行われ、その結果がサービスマネージャに送られて、対応するアプリやサービスに照会。得られた答えを合成音声で返される。右の図はスタンフォード大学の自然言語処理コースの資料を基に作成。