2017.08.25

第5回 「CEDEC 2017」セッション「人狼知能大会:しゃべる人狼知能~人工知能による自然言語人狼対戦」のみどころ

人狼知能プロジェクトでは、人狼知能大会を開催し、その成果を国内最大級のエンターテインメント業界イベントである「コンピュータエンターテインメントデベロッパーズカンファレンス2017」(CEDEC 2017)のセッションで公開します。セッションは8月30日(水) 14:50~17:30、パシフィコ横浜で開催されます。今回は、その見どころを紹介していきます。

「CEDEC 2017」セッション「しゃべる人狼知能~人工知能による自然言語人狼対戦」

http://cedec.cesa.or.jp/2017/session/AC/s58e0a90d982da/

セッションの種別は「CEDEC Challenge」です。CEDECへの参加は有料ですが、このセッションには「レギュラーパス(3日間)」「デイリーパス(1日間)」「エキスポパス(1日間、特定セッションのみ)」のいずれでも参加できます。

電子書籍『人狼知能で学ぶAIプログラミング 欺瞞・推理・会話で不完全情報ゲームを戦う人工知能の作り方』をマナティで発売中!

(上の書籍画像をクリックすると購入サイトに移動できます)

1. 「CEDEC 2017」の人狼知能大会セッション概要

本連載の第1回で触れたように、人狼知能同士を対戦させる「人狼知能大会」が、今年もCEDECのセッションとして開催されます。今年は、初めての試みとして、自然言語(日本語)で自動対戦させる「自然言語部門」が開催されます。対戦の概要、意義、結果の解説に加えて、人間との対戦も予定しています。人間と会話するプログラムである対話システムの将来と応用について、ぜひ一緒に考えましょう。セッションでは、プロトコル部門と自然言語部門双方の結果発表やデモンストレーション、解説を行いますが、今回は初めての試みである自然言語部門に多くの時間を割く予定です。

コンピュータが自然言語で人狼ゲームをプレイできたら、それだけでとても楽しいには違いありません。のみならず、そこには技術の進歩という点で大きな意義があります。今回は対話システムの評価という点での意義を説明し、CEDECでの見どころを紹介します。

2. 自然言語部門の意義:対話システムの評価

2.1 対話破綻検出チャレンジ

「対話破綻検出チャレンジ」は、雑談対話システムと人間の対話ログから破綻(システムが文脈的に不適切な応答をした箇所)を検出する技術(対話破綻検出)に焦点を当て、参加者が各自開発した手法や技術を持ち寄ることで互いの技術を高め合うことを目的とした学術的なタスクです。※1システムの発話が破綻しているかどうかを自動判定できれば、そういったシステム発話を抑制することで、より自然な応答を返す対話システムが構築できます。また、対話が破綻する理由を探究すること自体にも大きな意義があります。

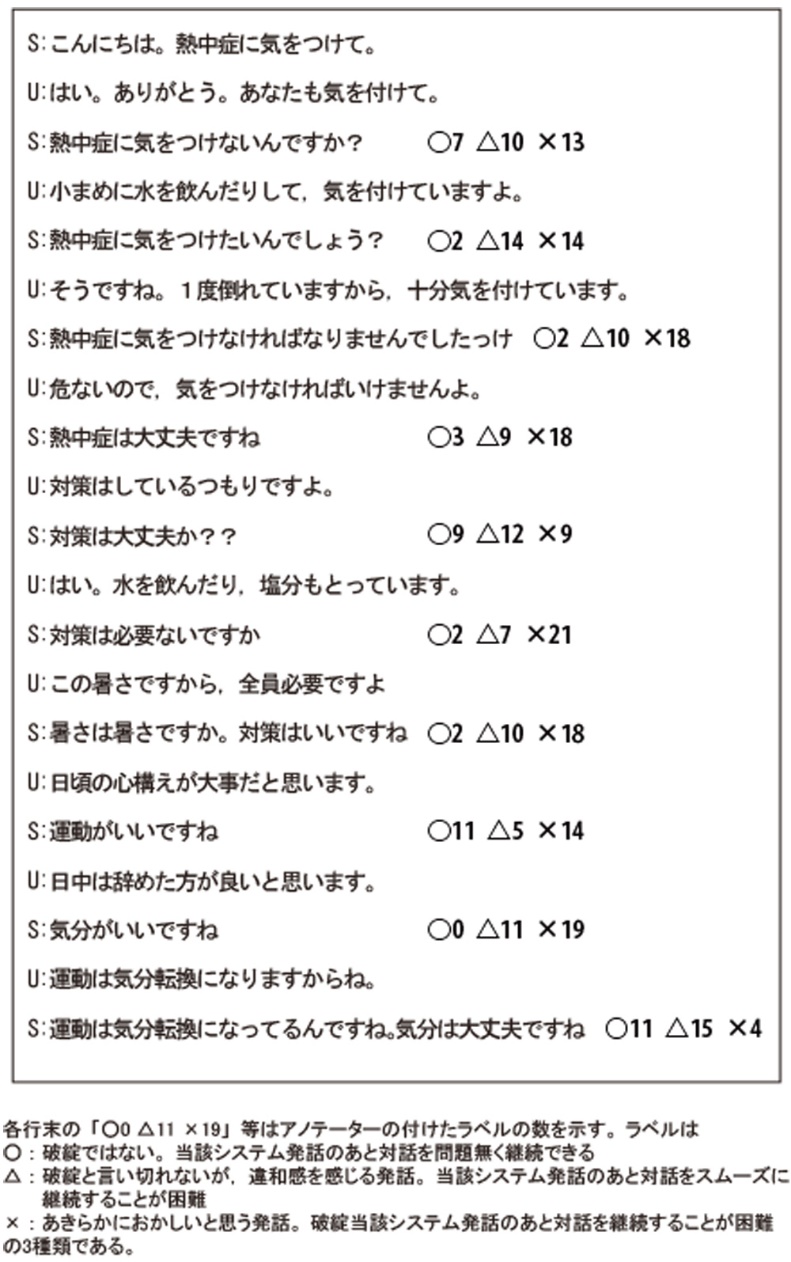

このタスクの開催にあたって、対話システムとユーザーのテキスト対話が記録された対話データが参加者に配布されました。これは一般にも公開されています。この対話データには、システムとユーザーの発話したテキストに加えて、アノテーター(評価者)が各発話ペアについて対話が成り立っているかどうかの「アノテーション」(正解ラベル)を付与しています。ラベルは、○、△,×の3種類で、同一のシステム発話に対して複数のアノテーターが付与しています(図2)。

図2の例について「ラベルをつける」という視点で考えると、この課題の難しさがわかります。アノテーターの判断も割れていますが、実際のところ、破綻と不自然の間くらいのものが多いように思えます。たとえば、例の最後の部分で「U:運動は気分転換になりますからね。」に対して、システムが「S:運動は気分転換になってるんですね。気分は大丈夫ですね」と答えています。このシステム発話に対するアノテーターの評価は「○11 △15 ×4」で、おそらく後半の「気分は大丈夫ですね」という部分をおかしいと考えるか、意味としては正しいと解釈したかで判断が分かれたのではないでしょうか。

対話が「破綻」と考える理由も、口調が不自然であるというものから過去の対話内容を「理解」していないだろうと思われるものまで、さまざまです。解決に必要と考えられる要素技術としても、語彙の不足から意味解析まで多岐に渡ります。システムの観点では、「単語のみを抽出して用いる」「過去に蓄積したデータをテンプレート的に利用して返す」といった原因で不自然になってしまった部分があるように見えます。

対話破綻検出チャレンジで提供されたデータのアノテーター間の一致率を示すκ統計量は0.2~0.5の範囲であり、一致率はかなり低いと考えられます。この種の課題では「正解」を決めるのは人間の認識であり、機械はそれをどこまで復元できるかが目標になります。そもそも人間同士が一致しない場合は機械にとっても困難なのです。

2.2 対話システムの評価:チューリングテスト

基準が明確でないのであれば、作成された対話システムの善し悪しはどうやって評価すればよいのでしょうか。テキストで対話文を与えたとき、その返答に対して自動的に何点と数値が出せれば低コストで評価ができてよいですが、どういうときに何点をつけるかということ自体が研究テーマであり、標準的な評価指標はありません。コストはかかりますが、何人かの人間に頼んでシステムの自然さを、たとえば5段階で評価してもらうような主観評価が主流です。

対話システムの評価として有名なものに「チューリングテスト」※2があります。評価者(人間)に,テキスト入出力のみに限定した状態で対話をしてもらい、相手が機械(コンピュータ)か人間かを見分けてもらうものです。機械でなく人間であると判定されればテストに合格したことになります。実際のテストは、時間制限を設けて、その間の対話で判定を行います。毎年、チューリングテストのコンテストに賞金を懸けて開催される「ローブナー賞」※3というものがあります。賞金額やルールは年によって異なりますが、2016年の場合は次のような設定でした(http://www.aisb.org.uk/events/loebner-prize)。

・4人の審査員が2人の相手とそれぞれ25分間やりとりをする

・この2人の相手のうち、片方は人間で、もう一方はシステムであり、審査員はどちらが人間かを推測する

・システムがインターネット接続することは許されていない

この2016年のローブナー賞に優勝した「Mitsuku」の開発者がシステムを公開しており、ブラウザで試すことができます(http://www.mitsuku.com/)。また、2014年には別のチューリングテストをパスしたというシステムが話題になりました。5分間のテストの後で、33%の審査員が人間であると判断しました。ただし、このシステムはEugene Goostmanというウクライナの13歳の少年という設定になっており、設定が影響し幼稚にみえる会話が許されたという面もありそうです(https://en.wikipedia.org/wiki/Eugene_Goostman)。

チューリングテストは本質的には妥当な評価基準ではないかと考えられますが、現実にはテスト時間が有限で、テストに合格することだけに特化すると、どうしても「制限時間内の逃げ切り」という方向になりがちです。その結果、第3回で紹介したELIZAと同様の表層的な情報の処理に終始していては、多くの人が期待する対話システムの未来の姿とは違ってしまうように思われます。そこで、人狼知能の出番です※4。

3. CEDEC 2017セッションの見どころ:自然言語による人狼知能エージェント

人狼ゲームに、ELIZAや、既存の対話システムがプレイヤーとして参加したら、どうなるでしょうか。たとえば「誰が人狼だと思う?」と問いかけられて、正面から答えずごまかすようなプレイヤーは怪しまれるでしょう。人狼ゲームにおいては、会話の内容は自由ですが、ゲームという設定があるため、タスク指向と非タスク指向の中間というべき対話システムが必要になります。しかも、不自然な受け答えをするということが、それだけで不適切なプレイヤーになりかねません。逆にいえば、人狼プレイヤーとして適切な人狼知能エージェントを作ることは、より自然な対話システムを目指すということになり、人狼ゲームに基づいた評価を行うことがその道しるべになりうると期待しています。

そのため、ゲームの勝敗は必ずしも重要ではありません。特に対話システムが未成熟な段階での機械対機械の対戦では、およそ対話が成立していないのに、ごく一部の情報だけで勝敗に影響を及ぼしてしまう可能性があり、勝敗以外の評価軸が重要となります。

3.1 みどころ1:機械同士の対戦とその仕組み、および評価

セッションでは、事前に行ったエージェント同士の対戦(5人人狼)ログをもとに、それぞれのエージェントの仕組みを解説し、人間による対話の主観評価を行います。どこまで自然な対戦ができるのか? よりよくするにはどうしたらよいか? 一緒に考えながら参加していただければと思います。

3.2 みどころ2:人間対機械の対戦デモ

自然言語エージェントなので、人間と機械のプレイヤーを混成した対戦が可能です。会場からのフィードバックをもらいつつ、機械と人間の対戦デモンストレーションを行います。何が起こるか未知数ですが、機械対機械の対戦を眺めるのと違い、「自分の対戦相手だ」と思うと全く違った感覚で見えてくると思います。さらに当日は、「人狼アイドル」が登場します。

3.3 見どころ3:???

人狼知能エージェントが人間並みに戦えるようになるまでには、まだまだ長い道のりでしょう。自然言語部分だけでも未解決の課題が数多くありますし、非言語の要素もさまざまあります。次の展開の1一つとして、宝塚大学東京メディア芸術学部の渡邉哲意研究室の協力を得て、図3の画像を使った「何か」を企画しています。当日の様子をお楽しみに。

※本稿の一部は、許可を得て下記原稿の一部を基にしています。

狩野 芳伸「コンピューターに話が通じるか:対話システムの現在」(『情報管理』Vol. 59、p.658~665、http://doi.org/10.1241/johokanri.59.658)

参考文献

※1 東中竜一郎、船越孝太郎、稲葉通将、荒瀬由紀、角森唯子、『対話破綻検出チャレンジ2』、人工知能学会 言語・音声理解と対話処理研究会 第78回研究会(第7回対話システムシンポジウム)、2016-10-5/6、人工知能学会、p.64-69

※2 Turing, A. M. Computing machinery and intelligence. Mind. 1950, vol. 59, no. 236, p. 433-460.

※3 "What is the Loebner Prize?". Loebner Prize. http://www.loebner.net/Prizef/loebner-prize.html, (accessed 2016-10-21).

※4 狩野芳伸、稲葉通将(2017)、『人狼知能大会における自然言語処理部門の構想』、言語処理学会第23回年次大会(NLP2017)、( http://www.anlp.jp/proceedings/annual_meeting/2017/pdf_dir/B1-5.pdf)